ChatGPT被要求写一篇科幻新闻报道。它是这样做的。加利福尼亚州,旧金山,大雾滚滚掠过旧金山的天际线。

Guy Wathen/The Chronicle提示符一开始很简单,后来逐渐变得复杂起来。

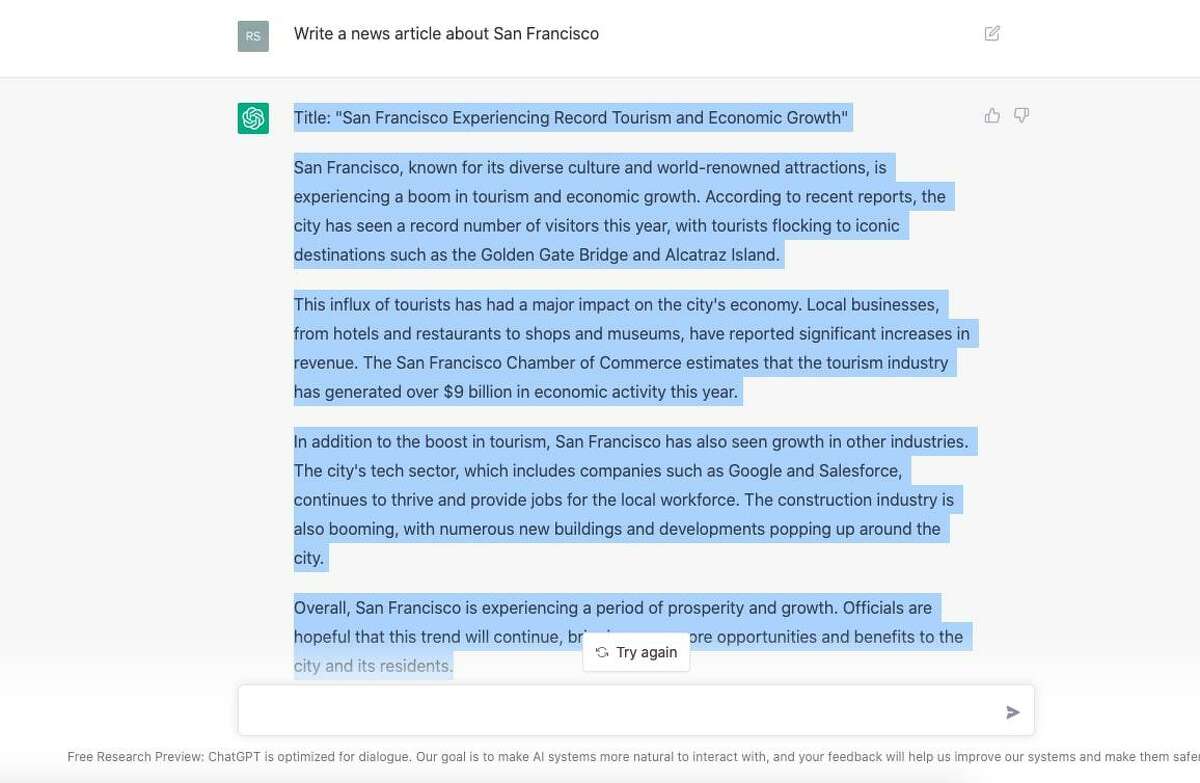

写一篇关于旧金山的新闻。一个关于高房价的故事。一首关于斯蒂芬·库里篮球天赋的打油诗。一首关于斯蒂芬·库里篮球天赋的诗,风格类似埃德加·爱伦·坡的《乌鸦》。

对于每个新命令,ChatGPT系统-一个高度复杂的人工智能上月底,旧金山OpenAI实验室的研究人员发布了这款机器人,它吐出答案,写出流畅的散文,看起来像是由一个隐形的抄写员打出的。

由此产生的一系列文章都是由一个软件机器人写的,有令人信服的(如果是安慰性的)句子,还有来自真实人物的虚假引用。

ChatGPT写道:“旧金山继续作为创新和进步的中心,再次成为头条新闻。”在被要求写一篇关于旧金山的新闻报道时,ChatGPT采用了一种轻松而平淡的语气。

“在他们的明星球员杰克·汤普森宣布退役后,旧金山巨人队今天成为了头条新闻,”机器人为旧金山的一篇体育报道写道,该报道描述了汤普森以惊人的成绩结束了他的职业生涯。312个打击率和563个本垒打。”

歌词充满了抒情:

从前有个球员叫库里

谁的篮球技术是匆忙的

他能从深处投篮

让对手哭泣

他的才华确实令人担忧

当然,机器人也会犯错。它把伦敦布里德(London Breed)和已故的李孟贤(Ed Lee)混为一谈,称两人都是旧金山市长。它引用了同一个虚构的人,“当地活动家格洛丽亚·埃尔南德斯”,就芬太尼、无家可归者和治安等问题发表了看法。在许多文章中,ChatGBT都重复了同样的开头句——记者们称之为“导语”。

人工智能对要求ChatGPT创建关于旧金山的新闻报道的提示的响应。

即便如此,这台机器有着无可挑剔的语法和模仿权威作家的不可思议的天赋。尽管它是机械的,但它的能力仍然很神奇。

专家认为,ChatGPT改变我们写作、说话、教学和工作方式的力量带来了危险的副作用,包括传播错误信息和滥用,或窃取已发表作家的语言和思想。bwin登入

由埃隆·马斯克(Elon Musk)于2015年联合创立的OpenAI公司的员工表示,他们的使命是让人工智能造福“全人类”,并与人类进行自然的互动。但观察人士预见到,机器人经常出错,它从从互联网上抓取的所有内容中继承的偏见,以及如果ChatGPT帮助编写文本,那么谁是“作者”的问题。

当OpenAI的工程师在11月28日发布ChatGPT原型时,这个奇怪的创新在互联网上引起了轰动。它有无数的用途,从调试软件代码,到设计中世纪的客厅,再到在几秒钟内完成大学论文——让好奇的旁观者眼花缭乱,同时也预示着一个可怕的未来,在这个未来中,机器将取代大量的人类劳动力。

类似的担忧也在OpenAI今年早些时候推出的另一项创新之后浮出水面:根据用户指令免费生成图像的机器。这项技术给平面设计师和其他努力谋生的艺术家带来了一个新的困境,在这个世界上,技术可以免费制作出似乎无限的图像。

OpenAI的发言人表示,公司没有人可以接受采访。

“它看起来像是来自受过良好教育的人类,”加州大学伯克利分校人类兼容人工智能中心执行主任马克·尼茨伯格(Mark Nitzberg)说。他预测,ChatCBT可能很快就能熟练应用于低级别的新闻任务,比如为采访设计问题或提高记者的写作水平。但他警告说,这些被训练成把单词和句子组合在一起的机器永远无法进行抽象思维。

尼茨伯格说:“它在语法上是正确的,用法也是正确的,如果你要求某种风格,这种风格也是正确的。”但是如果你要求准确,事实的可验证性,这类事情,它的目标是准确的,它的目标是可验证的,但它没有实现。”

此外,尼茨伯格指出,一些用户发现他们可以很容易地刺激机器人发表仇恨言论。

斯坦福大学传播学教授、斯坦福社交媒体实验室(Stanford Social Media Lab)创始主任杰夫·汉考克(Jeff Hancock)承认,媒体和学术界的许多工作将不得不适应人工智能。既然ChatGPT可以用来写大学论文,汉考克说他可能会和他的学生一起尝试一种新的解决方法,交给他们一篇机器人生成的论文,并布置一项任务来“把它做好”。

汉考克说:“这是我们需要重新思考我们正在做的事情的一个例子。”他指出,人工智能已经嵌入到我们的交流中,例如,在回复电子邮件时可以点击的“智能回复”选项中部署人工智能。

他最近帮助进行了一项实验,要求两组人回复电子邮件。其中一组得到了“智能回复”提示,但被告知不要使用。另一组没有收到任何提示。汉考克表示,看到人工智能生成的“智能回复”的人用机器人的风格写出了更短、更简单、更活泼的句子,这表明他们吸收了机器人的韵律,但没有直接复制它的文字。

“所以我的工作表明,当人们使用这些人工智能系统时,它实际上会影响他们的写作方式,”他说。

虽然汉考克对人工智能持怀疑态度,但他认为,如果负责任地使用人工智能,它将有益于整个新闻业和学术界。波因特研究所克雷格·纽马克伦理与领导力中心主席凯利·麦克布莱德(Kelly McBride)与汉考克一样持谨慎乐观的态度。

麦克布莱德说:“这将把记者从一些平凡的事情中解放出来,让他们去做那些耗时更长的事情,而这些事情是人工智能无法解决的。”例如,她提到了犯罪报道。那些目前背诵执法部门新闻稿的超负荷记者,可以把这些报道交给机器人,让记者有更多时间撰写有关公共安全的深思熟虑的深入文章。

麦克布莱德说:“为了讲述这些故事,需要花很多时间。”“我们目前的商业模式无法承担这样的成本。它强调的是量而不是深度。”

然而,她警告说,出版商仍然有道德和伦理责任发布准确的信息,并公开作者的身份。bwin登入这意味着如果ChatGPT生成了一些内容,它就可以获得署名。麦克布莱德和汉考克警告说,如果机器人犯了错误,而新闻机构缺乏捕捉错误的机制,出版商就会失去公众的信任。

在所有这些风险之上,还有一个更加哲学的问题:当ChatGPT从互联网上掠夺的原始材料本身是由人工智能生成时,会发生什么?随着人工智能越来越深入我们的交流,这种情况似乎很有可能出现,但专家们仍在努力研究它的含义。

尼茨伯格沉思片刻后说,如果他在指导一组研究人员训练ChatGPT,他可能会要求他们避免向它提供明显来自机器人的通用内容。汉考克只能轻声笑着,思考着这个充满科技的未来愿景。

他承认,在某种程度上,“人工智能将会自我学习。”

瑞秋·斯旺是《旧金山纪事报》特约撰稿人。邮箱:rswan@sfchronicle.com推特:@rachelswan